Utilisez notre test Apache Spark pour ingénieurs des données pour recruter la perle rare.

Sommaire du test Apache Spark pour ingénieurs des données

Ce test évalue la capacité d'un candidat à utiliser Apache Spark pour le traitement de données à grande échelle. Ce test d'embauche vous aidera à recruter des ingénieurs de données qui ont une expérience pratique de l'utilisation du framework Spark.

Compétences couvertes

Fondamentaux d'Apache Spark

Transformation et traitement des données

Spark Core

Spark Streaming/GraphX

Utilisez le test Apache Spark pour ingénieurs des données pour recruter

Ingénieurs des données

A propos du test Apache Spark pour ingénieurs des données

A l'ère du big data, les entreprises ont besoin d'outils puissants pour traiter et transformer ces données. Apache Spark est l'un des outils les plus puissants disponibles aujourd'hui pour les opérations de big data. Depuis sa sortie en 2009, son utilisation s'est accrue de façon exponentielle parmi les entreprises qui travaillent avec certains des plus grands ensembles de données.

Bien que l'un des principaux avantages de Spark soit sa facilité d'utilisation, il faut un ingénieur des données expérimenté pour tirer le meilleur parti de toutes ses fonctionnalités. Lorsque vous recrutez des ingénieurs des données connaissant bien Apache Spark, vos projets de données seront réalisés plus rapidement, ce qui permettra à votre entreprise de se concentrer sur la mise en œuvre des solutions que les données impliquent.

Ce test Apache Spark pour ingénieurs des données évalue les capacités des candidats à appliquer leur compréhension des principes fondamentaux d'Apache Spark, à utiliser Apache Spark pour la transformation et le traitement des données, à utiliser Spark Core et à utiliser Spark Streaming/Graph X.

Ce test de sélection vous aidera à identifier les ingénieurs des données et autres professionnels qui ont une solide expérience avec le framework Spark. Les candidats qui réussissent ce test sont capables de résoudre efficacement des problèmes et d'exécuter des scénarios Apache Spark courants qu'ils sont susceptibles de rencontrer dans le cadre de leur travail.

Le test est créé par un expert en la matière

Les tests de TestGorilla sont créés par des experts en la matière. Nous évaluons les experts potentiels en fonction de leurs connaissances, de leurs compétences et de leur réputation.Avant d'être publié, chaque test est relu par un autre expert, puis calibré en utilisant des centaines de candidats ayant une expérience pertinente dans le domaine.

os mécanismes de feedback et nos algorithmes uniques permettent à nos experts en la matière d'améliorer constamment leurs tests.

Hamza A.

Ingénieur en données Spark avec des années d'expérience dans le domaine des données, Hamza a travaillé sur une grande variété de projets d'apprentissage automatique, d'ingénierie des données et de web scraping, petits et grands.

Son intérêt et son dévouement pour le domaine des données l'ont amené à maîtriser le framework Spark et d'autres frameworks ETL, dont Apache Airflow. Il s'efforce continuellement de maîtriser la science des données graphiques.

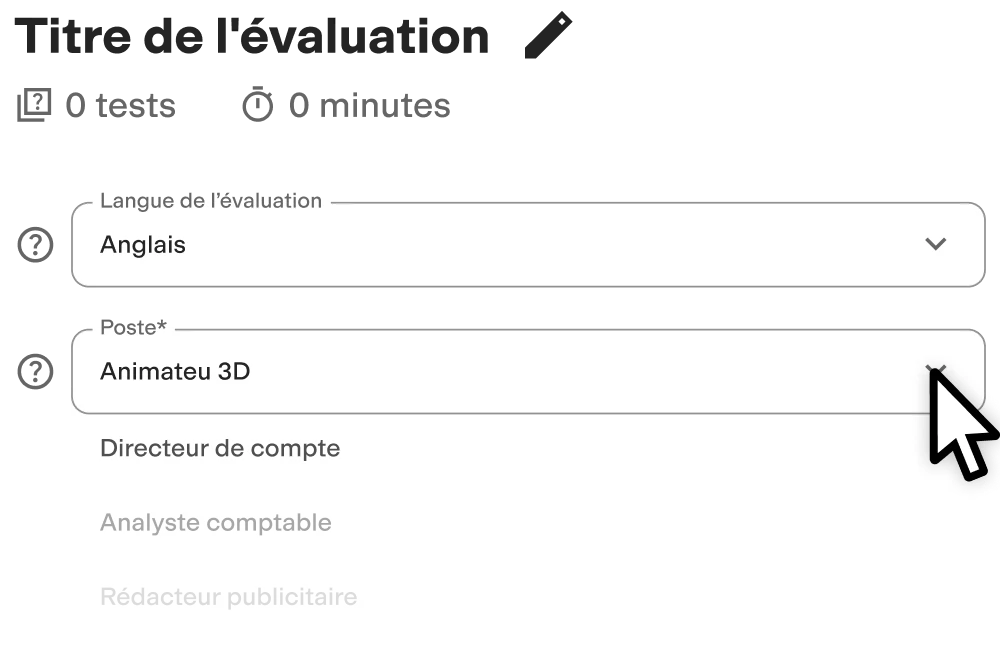

Créez des évaluations de haute qualité en quelques clics

Avec TestGorilla, créer des évaluations est un jeu d’enfant. Commencez par suivre ces étapes simples.